|

Обеспечение возобновления работы сетевых сервисов при аппаратных и программных сбоях системы

|

|

|

|

Обеспечение возобновления работы сетевых сервисов, в случае отказа может быть обеспечено при объединении гипервизоров в единый кластер виртуализации.

В терминологии XEN, кластер виртуализации это множество систем виртуализации, имеющих общую систему управления, единое хранилище данных и общие сетевые ресурсы. Внутри кластера возможна живая миграция доменов Xen.

Общие сетевые ресурсы будут обеспечены при добавлении обоих гипервизоров в единую изолированную подсеть, что уже было оговорено (сетевые интерфейсы для связи гипервизоров надо объединить и поместить в собственный vlan, связав с коммутационным стеком).

Единая система управления может быть обеспечена, например, через менеджер виртуальных машин "virt-manager". Для этого должен быть создан защищенный туннель с помощью OpenSSH. Настройка туннеля в OpenSSH происходит после генерации открытого и закрытого ключа утилитой "ssh-keygen", далее настраивается аутентификация по ключам shh. Настройки управления осуществляются самой утилитой virt-manager, в которой надо добавить туннели на соответствующие сетевые адреса гипервизоров XEN.

Важным моментом является организация единого ресурса, для хранения файлов виртуальных машин. Для этого можно использовать следующие возможности:

- DRBD (Distributed Replicated Block Device - распределённое реплицируемое блочное устройство). Это блочное устройство, предназначенное для построения отказоустойчивых кластерных систем для ОС Linux. DRBD занимается полным отражением (mirroring) по сети всех операций с блочным устройством.

- AoE (ata over ethernet) и vbalde. Это набор утилит, позволяющих "пробросить" ATA устройства через ethernet.

- Средства iSCSI для подключения носителей хранилища к гипервизору в качестве блочного устройства.

|

|

|

- NFS (Network File System) - самый простой вариант единого хранилища (но при этом несколько медленнее iSCSI).

В силу скорости работы и предоставляемых возможностей для организации единого хранилища будут использованы средства iSCSI.

iSCSI (Internet Small Computer System Interface) - протокол, который базируется на TCP/IP и разработан для установления взаимодействия и управления системами хранения данных, серверами и клиентами. iSCSI работает на блочном уровне. Объектом, к которому предоставляется доступ, является область данных, интерпретируемая инициатором как блочное устройство (диск). Доступ является монопольным (за исключением специально рассчитанных на это файловых систем и файловых систем в режиме "только для чтения"). Обязанность создавать и обслуживать файловую систему возлагается на инициатора; сервер (цель, target) лишь обслуживает низкоуровневые запросы, аналогичные запросам, которые обслуживает драйвер диска при работе с локальными дисками. Выбранные для проектируемого ЦОД сетевые хранилища (NAS) в полной мере поддерживают протокол iSCSI, что позволит подключать раздел основного хранилища как блочное устройство.

Для размещения виртуальных машин XEN в пространстве сетевого хранилища как файлов следует использовать специальную кластерную файловую систему GFS (Global File System), которая поддерживается дистрибутивами Red Hat Enterprise Linux (соответственно и CentOS).

Высокая скорость работы с сетевым хранилищем (до 5Гбит/s), обусловлена агрегацией каналов на уровне NAS <=> коммутационный стек.

При выборе аппаратной конфигурации была предусмотрена дальнейшая возможность наращивания производительности сетевого соединения для связи с хранилищами.

XEN поддерживает возможность работы виртуальной машины непосредственно на блочном устройстве (файловая система создается уже самой виртуализированной ОС, но XEN про это ничего "не знает"). Поэтому второй способ работы с виртуальными машинами в едином хранилище, это размещение их непосредственно в разделах NAS, подключенных средствами iSCSI.

|

|

|

Последний этап настройки гипервизоров, для объединения в кластер, это правка файлов конфигурации XEN и открытие необходимого TCP порта под номером "8002" на всех гипервизорах.

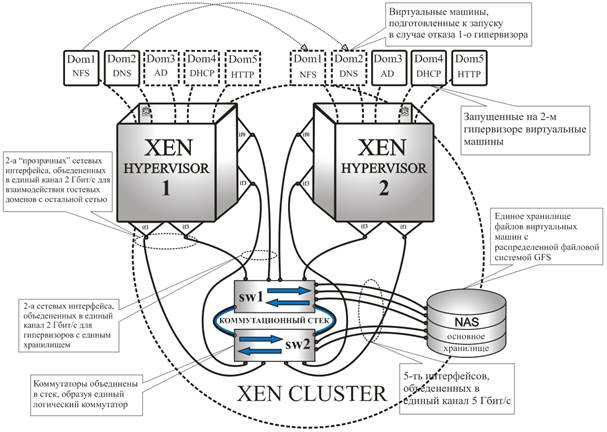

Схема виртуальной среды в пространстве кластера XEN показана на рисунке 7.4:

Рисунок 7.4 "Концепция кластера XEN"

После создания кластера становится возможна работа живая миграция (как и обычная миграция) доменов между гипервизорами. Живая миграция -это перенос виртуальной машины с одного физического сервера на другой без прекращения работы ВМ и остановки сервисов. Процесс живой миграции следующий:

-Остановка выполнения ВМ.

-Передача параметров ВМ с сервера исходного расположения ВМ на сервер целевого расположения.

-Передача образа оперативной памяти с сервера исходного расположения ВМ на сервер целевого расположения.

-Создание виртуально домена и размещение образа оперативной памяти в RAM сервера целевого расположения.

-Запуск выполнения ВМ на сервере целевого расположения.

-Уничтожение ВМ на сервере исходного расположения.

(этот процесс занимает меньше секунды)

Загрузочные разделы операционных систем гостевых доменов следует разместить на быстрых твердотельных накопителях SSD основного хранилища NAS. Для хранения прочих файлов следует использовать менее быстрые накопители SAS.

При сбое одного из гипервизоров на аппаратном или программном уровне за счет единого хранилища и кластерной организации будет возможность продолжения работы виртуализированных сетевых сервисов на другом гипервизоре. Это достигается следующим методом:

При разрыве связи между узлами каждый узел определяет, по какой причине он не видит второй узел. Здесь возможны два варианта:

-Узел видит, что он изолирован (то есть, не видит не только свою вторую половину, но и вообще никого). В этом случае он выключает все домены.

-Узел видит, что проблема с его второй половиной (то есть вторая половина не видится, но все остальные контрольные точки сети доступны). В этом случае он запускает у себя все недостающие домены.

|

|

|

С точки зрения внешнего наблюдателя это происходит незаметно, для машин уцелевшего узла. Но это выглядит как перезагрузка машины, для машин, которые остались на потерянном узле (работа которых была возобновлена на другом гипервизоре).

Схема сети, с учетом коммутационного оборудования в стеке и использованных систем виртуализации показана на рисунке 7.5:

Рисунок 7.5 "Схема сети ЦОД"

Звено управляющих компьютеров надо расположить в сетевом сегменте гипервизоров и сетевых хранилищ. Из этого сегмента можно получить доступ как к управлению гипервизоров (SSH,virt-manager) и сетевых хранилищ, так и к управлению ОС виртуальных машин (xen-console, VNC или собственные терминальные клиенты установленных ОС). При этом для всей остальной сети (пользовательские сегменты) прямой доступ к гипервизорам и сетевым хранилищам будет закрыт.

|

|

|