|

Проблемы современной механики

|

|

|

|

К числу основных проблем современной механики систем с конечным числом степеней свободы относятся, в первую очередь, задачи теории колебаний, динамики твердого тела и теории устойчивости движения. В линейной теории колебаний важное значение имеет создание эффективных методов исследования систем с периодически изменяющимися параметрами, в частности, явления параметрического резонанса. Для изучения движения нелинейных колебательных систем разрабатываются как аналитические методы, так и методы, основанные на качественной теории дифференциальных уравнений. Проблемы колебаний тесно переплетаются с вопросами радиотехники, автоматического регулирования и управления движениями, а также с задачами измерения, предупреждения и устранения вибраций в транспортных устройствах, машинах и строительных сооружениях. В области динамики твердого тела наибольшее внимание уделяется задачам теории колебаний и теории устойчивости движения. Эти задачи ставятся динамикой полета, динамикой корабля, теорией гироскопических систем и приборов, применяемых главным образом в аэронавигации и кораблевождении. В теории устойчивости движения на первое место выдвигается исследование “особых случаев” Ляпунова, устойчивости периодических и неустановившихся движений, причем основным орудием исследования является так называемая “вторая метода Ляпунова”.

В теории упругости наряду с задачами для тела, подчиняющегося закону Гука, наибольшее внимание привлекают вопросы пластичности и ползучести в деталях машин и сооружений, расчет устойчивости и прочности тонкостенных конструкций. Большое значение приобретает также направление, ставящее себе целью установление основных законов связи напряжений с деформациями и скоростями деформаций для моделей реальных тел (реологические модели). В тесной связи с теорией пластичности развивается механика сыпучей среды. Динамические проблемы теории упругости связывают с сейсмологией, распространением упругих и пластичных волн вдоль стержней и динамическими явлениями, возникающими при ударе.

|

|

|

Наиболее важные задачи гидроаэродинамики связаны с проблемами больших скоростей в авиации, баллистике, турбостроении и двигателестроении. Сюда относятся, прежде всего, теоретическое определение аэродинамических характеристик тел при до-, около- и сверхзвуковых скоростях как при установившемся, так и неустановившемся движениях. Проблемы аэродинамики больших скоростей тесно переплетаются с вопросами теплоотдачи, горения и взрывов. Изучение движений сжимаемого газа при больших скоростях предполагает основную проблему газовой динамики, а при малых скоростях связывается с задачами динамической метеорологии. Основное значение для гидроаэродинамики имеет проблема турбулентности, до сих пор еще не получившая теоретического решения. На практике продолжают пользоваться многочисленными эмпирическими и полуэмпирическими формулами. Перед гидродинамикой тяжелой жидкости стоят проблемы пространственной теории волн и волнового сопротивления тел, волнобразования в реках и каналах и ряд задач, связанных с гидротехникой. Большое значение для последней, а также для вопросов добычи нефти имеют проблемы фильтрационного движения жидкостей и газов в пористых средах.

1 Тензор деформации (в механике сплошных сред) – величина, характеризующая состояние деформированного упругого тела в точке сплошной среды. Понятие тензора как функции точки используют в тензорном анализе и применяют в основном в теории поля в физике. Тензорные методы позволяют проследить на относительно простой математической модели изменение сложных количественных характеристик при переходе из одной системы отсчета к другой.

|

|

|

2 Тензор инерции – величина, характеризующая распределение массы в твердом теле по отношению к взятой точке.

3 Тензор напряжения (в механике сплошных сред) – величина, характеризующая напряженное состояние в данной точке сплошного тела.

4 Стационарные связи – связи, не зависящие от времени. Идеальные связи – связи без трения.

5 Активные силы – силы, которые, действую на покоящуюся систему, могут сообщить ей то или иное движение.

6Неосвобождающая связь – такая связь, что ее влияние не может прекратиться или, другими словами, система не может освободиться от связи.

7Освобождающая связь – такая связь, что система может покинуть связь.

8 Статика - раздел механики, в котором изучают законы равновесия тел под действием приложенных к ним сил законы преобразования систем сил, действующих на твердые тела.

9 Консервативная система – механическая система, к которой применим закон сохранения механической энергии: T+U=const, где T - кинетическая энергия, а U – потенциальная энергия.

10 Сила инерции равна произведению массы точки на ее ускорение.

11 Нестационарная связь – связь, зависящая от времени.

12 Обобщенные силы – величины, определяемые формулой: Qj = ¶L / ¶qj, где Qj – обобщенные силы, а L -функция Лагранжа (см. выше).

Электромеханический этап

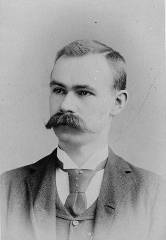

Герман Холлерит (Herman Hollerith, 1860–1929)

Герман Холлерит (Herman Hollerith, 1860–1929)

Электромеханический этап развития ВТ явился наименее продолжительным и охватывает всего около 60 лет — от первого табулятора Германа Холлерита (1887 г.) до первой ЭВМ ЕNIАС (1945 г.). Предпосылками создания проектов данного этапа явились как необходимость проведения массовых расчетов (экономика, статистика, управление и планирование и др.), так и развитие прикладной электротехники (электропривод и электромеханические реле), позволившие создавать электромеханические вычислительные устройства. Если вернуться к предыдущим этапам развития ВТ, то можно заметить, что каждый этап характеризуется созданием технических средств нового типа, обладающих более высокой производительностью и более широкой сферой применения, чем предыдущие этапы. Классическим типом средств электромеханического этапа был счетно-аналитический комплекс, предназначенный для обработки информации на перфокарточных носителях.

|

|

|

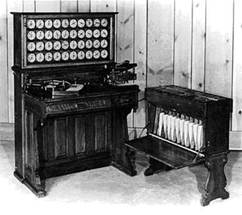

Первый счетно-аналитический комплекс был создан в США Г. Холлеритом в 1887 г. и состоял из ручного перфоратора, сортировочной машины и табулятора. Значение работ Г. Холлерита для развития ВТ определяется двумя основными факторами. Во-первых, он стал основоположником нового направления в ВТ — счетно-перфорационного (счетно-аналитического), состоящего в применении табуляторов и сопутствующего им оборудования для выполнения широкого круга экономических и научно-технических расчетов. На основе этой ВТ создаются машинно-счетные станции для механизированной обработки информации, послужившие прообразом современных вычислительных центров (ВЦ). В 20—30-е годы 20 века применение счетно-перфорационной техники становится ведущим фактором развития ВТ; только появление ЭВМ ограничило ее применение.

Табулирующая машина Г.Холлерита

Во-вторых, даже после прекращения использования табуляторов основным носителем информации (ввод/вывод) для ЭВМ остается перфокарта, а в качестве периферийных используются перфокарточные устройства (например перфораторы), предложенные Холлеритом. Даже в наше время использование большого числа разнообразных устройств ввода/вывода информации не отменило полностью использования перфокарточной технологии. Прежде всего, это относится к большим и супер-ЭВМ. Таким образом, перфокарточная технология обработки информации с использованием ВТ, впервые предложенная Бэбиджем и реализованная Холлеритом, до сих пор не сдана в музей истории вычислительной техники.

Последним же крупным проектом следует считать построенную в 1957 г. в СССР релейную вычислительную машину (РВМ-1) и эксплуатирующуюся до конца 1964 г. в основном для решения экономических задач. Например, на ней производился перерасчет цен на товары в связи с денежной реформой 1961 г. Создание модели РВМ-1 хоть и было весьма запоздалым, но проект ее был чрезвычайно удачным и представляется нам венцом развития релейной ВТ; РВМ-1 на целом ряде задач была вполне конкурентоспособна с ЭВМ того времени, весьма надежна и ее быстродействие было на уровне первых малых ЭВМ

|

|

|

В 1949 году в США был создан первый полупроводниковый прибор, заменяющий электронную лампу. Он получил название транзистор. В 60-х годах транзисторы стали элементной базой для ЭВМ второго поколения. Переход на полупроводниковые элементы улучшил качество ЭВМ по всем параметрам: они стали компактнее, надежнее, менее энергоемкими. Быстродействие большинства машин достигло десятков и сотен тысяч операций в секунду. Объем внутренней памяти возрос в сотни раз по сравнению с ЭВМ первого поколения. Большое развитие получили устройства внешней (магнитной) памяти: магнитные барабаны, накопители на магнитных лентах. Благодаря этому появилась возможность создавать на ЭВМ информационно-справочные, поисковые системы (это связано с необходимостью длительно хранить на магнитных носителях большие объемы информации). Во времена второго поколения активно стали развиваться языки программирования высокого уровня. Первыми из них были ФОРТРАН, АЛГОЛ, КОБОЛ. Программирование как элемент грамотности стало широко распространяться, главным образом среди людей с высшим образованием.

Электромеханический этап:

* Первый счетно-аналитический комплекс был создан в США в 1887 г. с использованием идей Беббиджа и Джоккарда, Г. Холлеритом (табулятор Холлерита). Он использовался для переписи населения в России (1897 г.), США (1890 г.) и Канаде (1897 г.), для обработки отчетности на железных дорогах США, в крупных торговых фирмах.

* В 1941 г. Конрад Цузе построил аналогичную машину, с программным управлением и запоминающим устройством.

* В 1944 г. Айкен на предприятии фирмы IBM, с помощью работ Бэббиджа, построил аналитическую машину "МАРК-1" на электромеханическом реле. Скорость вычислений этой машины была в 100-крат быстрее арифмометра с электроприводом. Было создано несколько модификаций этой машины.

* В СССР в 1957 г. была построена релейная вычислительная машина (РВМ-1). Это был последний, крупный проект релейной ВТ. В этот период создаются машинно-счетные станции, которые являлись предприятиями механизированного счета.

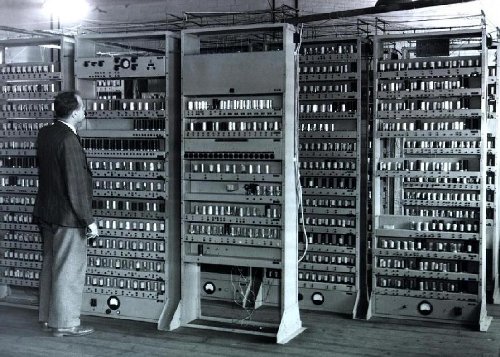

Электронный этап

* С 1943- 45 г. группа под руководством Мочли и Эккерта в США создает первую ЭВМ ENIAC на основе ЭКЕКТРОННЫХ ЛАМП. Это была универсальная машина для решения разного рода задач. Эта ЭВМ превосходила производительностью машину МАРК-1 в 1000 раз и была больше неё в 2 раза (вес- 30 т.). ENIAC содержала 18000 электронных ламп, 150 реле, 70000 резисторов, 10000 конденсаторов, потребляя мощность в 140 кВт. Но у нее не было памяти и для задания программы надо было соединить определенным образом провода.

|

|

|

| Этап | Период развития |

| Ручной | не установлен |

| Механический | с середины XVII в |

| Электромеханический | с 90-х годов XIX в |

| Электронный | с 40-х годов ХХ в |

* В 1945 г. Джон фон Нейман разработал общие принципы построения цифровой вычислительной машины, которые до сих пор используются в современных ПК.

Согласно этим принципам Джона фон Неймана, компьютер должен иметь:

* арифметическо - логическое устройство, выполняющее арифметические и логические операции;

* устройство управления, которое организует процесс выполнения программ;

* запоминающее устройство, или память для хранения программ и данных;

* внешнее устройство для ввода-вывода информации

Электронный этап

со второй половины 40-х годов XX в.

Электронный этап (создание ЭВМ) начинается с созданием в 1945г. в США электронной вычислительной машины ENIAK. В истории развития ЭВМ 5 поколений, которые отличаются в элементарной базе, логической архитектуре и программном обеспечении, различаются по быстродействию, оперативной памяти, способам ввода и вывода информации.

Электронный этап можно разделить на Поколения ЭВМ:

ЭВМ 1-го поколения

После создания в 1949 г. в Англии модели EDSAC был дан мощный импульс развитию универсальных ЭВМ, стимулировавший появление в ряде стран моделей ЭВМ, составивших первое поколение. На протяжении более 40 лет развития вычислительной техники(ВТ) появилось, сменяя друг друга, несколько поколений ЭВМ.

ЭВМ первого поколения в качестве элементной базы использовали электронные лампы и реле; оперативная память выполнялась на триггерах, позднее на ферритовых сердечниках; быстродействие было, как правило, в пределах 5—30 тыс. арифметических оп/с; они отличались невысокой надежностью, требовали систем охлаждения и имели значительные габариты. Процесс программирования требовал значительного искусства, хорошего знания архитектуры ЭВМ и ее программных возможностей. На первых порах данного этапа использовалось программирование в кодах ЭВМ (машинный код), затем появились автокоды и ассемблеры. Как правило, ЭВМ первого поколения использовались для научно-технических расчетов, а сам процесс программирования больше напоминал искусство, которым занимался весьма узкий круг математиков, инженеров-электриков и физиков.  ЭВМ EDSAC, 1949 г.

ЭВМ 2-го поколения

Создание в США 1 июля 1948 г. первого транзистора не предвещало нового этапа в развитии ВТ и ассоциировалось, прежде всего, с радиотехникой. На первых порах это был скорее опытный образец нового электронного прибора, требующий серьезного исследования и доработки. И уже в 1951 г. Уильям Шокли продемонстрировал первый надежный транзистор. Однако стоимость их была достаточно велика (до 8 долларов за штуку), и только после разработки кремниевой технологии цена их резко снизилась, способствовав ускорению процесса миниатюризации в электронике, захватившего и ВТ.

Общепринято, что второе поколение начинается с ЭВМ RCA-501, появившейся в 1959 г. в США и созданной на полупроводниковой элементной базе. Между тем, еще в 1955 г. была создана бортовая транзисторная ЭВМ для межконтинентальной баллистической ракеты ATLAS. Новая элементная технология позволила резко повысить надежность ВТ, снизить ее габариты и потребляемую мощность, а также значительно повысить производительность. Это позволило создавать ЭВМ с большими логическими возможностями и производительностью, что способствовало распространению сферы применения ЭВМ на решение задач планово-экономических, управления производственными процессами и др. В рамках второго поколения все более четко проявляется дифференциация ЭВМ на малые, средние и большие. Конец 50-х годов характеризуется началом этапа автоматизации программирования, приведшим к появлению языков программирования Fortran (1957 г.), Algol-60 и др.

ЭВМ 3-го поколения

Третье поколение связывается с появлением ЭВМ с элементной базой на интегральных схемах (ИС). В январе 1959 г. Джеком Килби была создана первая ИС, представляющая собой тонкую германиевую пластинку длиной в 1 см. Для демонстрации возможностей интегральной технологии фирма Texas Instruments создала для ВВС США бортовой компьютер, содержащий 587 ИС, и объемом (40см3) в 150 раз меньшим, чем у аналогичной ЭВМ старого образца. Но у ИС Килби был ряд существенных недостатков, которые были устранены с появлением в том же году планарных ИС Роберт Нойса. С этого момента ИС-технология начала свое триумфальное шествие, захватывая все новые разделы современной электроники и, в первую очередь, вычислительную технику.

Значительно более мощным становится программное обеспечение, обеспечивающее функционирование ЭВМ в различных режимах эксплуатации. Появляются развитые системы управления базами данных (СУБД), системы автоматизирования проектных работ (САПР); большое внимание уделяется созданию пакетов прикладных программ (ППП) различного назначения. По-прежнему появляются новые и развиваются существующие языки и системы программирования.

ЭВМ 4-го поколения

Конструктивно-технологической основой ВТ 4-го поколения становятся большие (БИС) и сверхбольшие (СБИС) интегральные схемы, созданные соответственно в 70—80-х гг. Такие ИС содержат уже десятки, сотни тысяч и миллионы транзисторов на одном кристалле (чипе). При этом БИС-технология частично использовалась уже и в проектах предыдущего поколения (IВМ/360, ЕС ЭВМ ряд-2 и др.). Наиболее важный в концептуальном плане критерий, по которому ЭВМ 4-го поколения можно отделить от ЭВМ 3-го поколения, состоит в том, что первые проектировались уже в расчете на эффективное использование современных ЯВУ и упрощения процесса программирования для проблемного программиста. В аппаратном отношении для них характерно широкое использование ИС-технологии и быстродействующих запоминающих устройств. Наиболее известной серией ЭВМ четвертого поколения можно считать IВМ/370, которая в отличие от не менее известной серии IВМ/360 3-го поколения, располагает более развитой системой команд и более широким использованием микропрограммирования. В старших моделях 370-й серии был реализован аппарат виртуальной памяти, позволяющий создавать для пользователя видимость неограниченных ресурсов оперативной памяти.

Феномен персонального компьютера (ПК) восходит к созданию в 1965 г, первой мини-ЭВМ PDP-8, которая появилась в результате универсализации специализированного микропроцессора для управления ядерным реактором. Машина быстро завоевала популярность и стала первым массовым компьютером этого класса; в начале 70-х годов число машин превысило 100 тысяч шт. Дальнейшим важным шагом был переход от мини- к микро-ЭВМ; этот новый структурный уровень ВТ начал формироваться на рубеже 70-х годов, когда появление БИС дало возможность создать универсальный процессор на одном кристалле. Первый микропроцессор Intel-4004 был создан в 1971 г. и содержал 2250 элементов, а первый универсальный микропроцессор Intel-8080, явившийся стандартом микрокомпьютерной технологии и созданный в 1974 г., содержал уже 4500 элементов и послужил основой для создания первых ПК. В 1979 г. выпускается один из самых мощных и универсальных 16-битный микропроцессор Motorolla-68000 с 70 000 элементами, а в 1981 г. — первый 32-битный микропроцессор Hewlett Packard с 450 тыс. элементами. ЭВМ EDSAC, 1949 г.

ЭВМ 2-го поколения

Создание в США 1 июля 1948 г. первого транзистора не предвещало нового этапа в развитии ВТ и ассоциировалось, прежде всего, с радиотехникой. На первых порах это был скорее опытный образец нового электронного прибора, требующий серьезного исследования и доработки. И уже в 1951 г. Уильям Шокли продемонстрировал первый надежный транзистор. Однако стоимость их была достаточно велика (до 8 долларов за штуку), и только после разработки кремниевой технологии цена их резко снизилась, способствовав ускорению процесса миниатюризации в электронике, захватившего и ВТ.

Общепринято, что второе поколение начинается с ЭВМ RCA-501, появившейся в 1959 г. в США и созданной на полупроводниковой элементной базе. Между тем, еще в 1955 г. была создана бортовая транзисторная ЭВМ для межконтинентальной баллистической ракеты ATLAS. Новая элементная технология позволила резко повысить надежность ВТ, снизить ее габариты и потребляемую мощность, а также значительно повысить производительность. Это позволило создавать ЭВМ с большими логическими возможностями и производительностью, что способствовало распространению сферы применения ЭВМ на решение задач планово-экономических, управления производственными процессами и др. В рамках второго поколения все более четко проявляется дифференциация ЭВМ на малые, средние и большие. Конец 50-х годов характеризуется началом этапа автоматизации программирования, приведшим к появлению языков программирования Fortran (1957 г.), Algol-60 и др.

ЭВМ 3-го поколения

Третье поколение связывается с появлением ЭВМ с элементной базой на интегральных схемах (ИС). В январе 1959 г. Джеком Килби была создана первая ИС, представляющая собой тонкую германиевую пластинку длиной в 1 см. Для демонстрации возможностей интегральной технологии фирма Texas Instruments создала для ВВС США бортовой компьютер, содержащий 587 ИС, и объемом (40см3) в 150 раз меньшим, чем у аналогичной ЭВМ старого образца. Но у ИС Килби был ряд существенных недостатков, которые были устранены с появлением в том же году планарных ИС Роберт Нойса. С этого момента ИС-технология начала свое триумфальное шествие, захватывая все новые разделы современной электроники и, в первую очередь, вычислительную технику.

Значительно более мощным становится программное обеспечение, обеспечивающее функционирование ЭВМ в различных режимах эксплуатации. Появляются развитые системы управления базами данных (СУБД), системы автоматизирования проектных работ (САПР); большое внимание уделяется созданию пакетов прикладных программ (ППП) различного назначения. По-прежнему появляются новые и развиваются существующие языки и системы программирования.

ЭВМ 4-го поколения

Конструктивно-технологической основой ВТ 4-го поколения становятся большие (БИС) и сверхбольшие (СБИС) интегральные схемы, созданные соответственно в 70—80-х гг. Такие ИС содержат уже десятки, сотни тысяч и миллионы транзисторов на одном кристалле (чипе). При этом БИС-технология частично использовалась уже и в проектах предыдущего поколения (IВМ/360, ЕС ЭВМ ряд-2 и др.). Наиболее важный в концептуальном плане критерий, по которому ЭВМ 4-го поколения можно отделить от ЭВМ 3-го поколения, состоит в том, что первые проектировались уже в расчете на эффективное использование современных ЯВУ и упрощения процесса программирования для проблемного программиста. В аппаратном отношении для них характерно широкое использование ИС-технологии и быстродействующих запоминающих устройств. Наиболее известной серией ЭВМ четвертого поколения можно считать IВМ/370, которая в отличие от не менее известной серии IВМ/360 3-го поколения, располагает более развитой системой команд и более широким использованием микропрограммирования. В старших моделях 370-й серии был реализован аппарат виртуальной памяти, позволяющий создавать для пользователя видимость неограниченных ресурсов оперативной памяти.

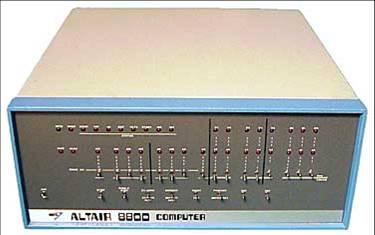

Феномен персонального компьютера (ПК) восходит к созданию в 1965 г, первой мини-ЭВМ PDP-8, которая появилась в результате универсализации специализированного микропроцессора для управления ядерным реактором. Машина быстро завоевала популярность и стала первым массовым компьютером этого класса; в начале 70-х годов число машин превысило 100 тысяч шт. Дальнейшим важным шагом был переход от мини- к микро-ЭВМ; этот новый структурный уровень ВТ начал формироваться на рубеже 70-х годов, когда появление БИС дало возможность создать универсальный процессор на одном кристалле. Первый микропроцессор Intel-4004 был создан в 1971 г. и содержал 2250 элементов, а первый универсальный микропроцессор Intel-8080, явившийся стандартом микрокомпьютерной технологии и созданный в 1974 г., содержал уже 4500 элементов и послужил основой для создания первых ПК. В 1979 г. выпускается один из самых мощных и универсальных 16-битный микропроцессор Motorolla-68000 с 70 000 элементами, а в 1981 г. — первый 32-битный микропроцессор Hewlett Packard с 450 тыс. элементами.  ПЭВМ Altair-8800

Первым ПК можно считать Altair-8800, созданный на базе микропроцессора Intel-8080 в 1974 г. Эдвардом Робертсом. Компьютер рассылался по почте, стоил всего 397 долларов и имел возможности для расширения периферийными устройствами (всего 256 байт ОЗУ!!!). Для Altair-8800 Пол Аллен и Бил Гейтс создали транслятор с популярного языка Basic, существенно увеличив интеллектуальность первого ПК (впоследствии они основали знаменитую теперь компанию Microsoft Inc). Комплектация ПК цветным монитором привела к созданию конкурирующей модели ПК Z-2; через год после появления первого ПК Altair-8800 их в производство ПК включилось более 20 различных ком-паний и фирм; начала формироваться ПК-индустрия (собственно производство ПК, их сбыт, периодические и непериодические издания, выставки, конференции и т.д.). А уже в 1977 г. были запущены в серийное производство три модели ПК Apple-2 (фирма Apple Computers), TRS-80 (фирма Tandy Radio Shark) и PET (фирма Commodore), из которых в конкурентной борьбе сначала отстающая фирма Apple становится вскоре лидером производства ПК (ее модель Apple-2 имела огромный успех). К 1980 г. корпорация Apple выходит на Уолл-стрит с самым большим акционерным капиталом и годовым доходом в 117 млн долларов.

Но уже в 1981 г. фирма IBM, во избежание потери массового рынка, начинает выпуск своих ныне широко известных серий ПК IBM PC/XT/AT и PS/2, открывших новую эпоху персональной ВТ. Выход на арену ПК-индустрии гиганта IBM ставит производство ПК на промышленную основу, что позволяет решить целый ряд важных для пользователя вопросов (стандартизация, унификация, развитое программное обеспечение и др.), которым фирма уделяла большое внимание уже в рамках производства серий IBM/360 и IBM/370. Можно с полным основанием полагать, что за короткий период времени, прошедший с дебюта Altair-8800 до IBM PC, к ВТ приобщилось больше людей, чем за весь долгий период — от аналитической машины Бэбиджа до изобретения первых ИС.

Первой ЭВМ, открывающей собственно класс супер-ЭВМ, можно считать модель Amdahl 470V16, созданную в 1975 г. и совместимую с IBM-серией. Машина использо-вала эффективный принцип распараллеливания на основе конвейерной обработки команд, а элементная база использовала БИС-технологию. В настоящее время к классу супер-ЭВМ относят модели, имеющие среднее быстродействие не менее 20 мегафлопсов (1 мегафлопс = 1 млн операций в с плавающей точкой в секунду). Первой моделью с такой производительностью явилась во многом уникальная ЭВМ ILLIAC-IV, созданная в 1975 г. в США и имеющая максимальное быстродействие порядка 50 мегафлопсов. Данная модель оказала огромное влияние на последующее развитие супер-ЭВМ с матричной архитектурой. Яркая страница в истории супер-ЭВМ связана с Cray-серией С. Крея, первая модель Cray-1 которой была создана в 1976 г. и имела пиковое быстродействие в 130 мегафлопсов. Архитектура модели базировалась на конвейерном принципе векторной и скалярной обработки данных с элементной базой на СБИС. Именно данная модель положила начало классу современных супер-ЭВМ. Следует отметить, что не смотря на ряд интересных архитектурных решений, успех модели был достигнут, в основном, за счет удачных технологических решений. Последующие модели Cray-2, Cray Х-МР, Cray-3, Cray-4 довели производительность серии до порядка 10 тыс. мегафлопсов, а модель Cray МР, использующая новую архитектуру на 64 процессорах и элементную базу на новых кремниевых микросхемах, обладала пиковой производительностью порядка 50 гигафлопсов.

Завершая экскурс в историю современной ВТ с той или иной детализацией отдельных ее этапов, следует сделать несколько существенных замечаний. Прежде всего, имеет место все более гладкий переход одного поколения ЭВМ к другому, когда идеи нового поколения в той или иной мере созревают и даже реализуются в предыдущем поколении. Особенно это заметно при переходе на ИС-технологию производства ВТ, когда определяющий акцент поколений все больше смещается с элементной базы на другие показатели: логическая архитектура, программное обеспечение, интерфейс с пользователем, сферы приложений и др. Появляется самая разнообразная ВТ, характеристики которой не укладываются в традиционные классификационные рамки; складывается впечатление, что мы находимся в начале своего рода универсализации ВТ, когда все ее классы стремятся к нивелированию своих вычислительных возможностей. Многие элементы пятого поколения в той или иной мере характерны и в наши дни.

ПЭВМ Altair-8800

Первым ПК можно считать Altair-8800, созданный на базе микропроцессора Intel-8080 в 1974 г. Эдвардом Робертсом. Компьютер рассылался по почте, стоил всего 397 долларов и имел возможности для расширения периферийными устройствами (всего 256 байт ОЗУ!!!). Для Altair-8800 Пол Аллен и Бил Гейтс создали транслятор с популярного языка Basic, существенно увеличив интеллектуальность первого ПК (впоследствии они основали знаменитую теперь компанию Microsoft Inc). Комплектация ПК цветным монитором привела к созданию конкурирующей модели ПК Z-2; через год после появления первого ПК Altair-8800 их в производство ПК включилось более 20 различных ком-паний и фирм; начала формироваться ПК-индустрия (собственно производство ПК, их сбыт, периодические и непериодические издания, выставки, конференции и т.д.). А уже в 1977 г. были запущены в серийное производство три модели ПК Apple-2 (фирма Apple Computers), TRS-80 (фирма Tandy Radio Shark) и PET (фирма Commodore), из которых в конкурентной борьбе сначала отстающая фирма Apple становится вскоре лидером производства ПК (ее модель Apple-2 имела огромный успех). К 1980 г. корпорация Apple выходит на Уолл-стрит с самым большим акционерным капиталом и годовым доходом в 117 млн долларов.

Но уже в 1981 г. фирма IBM, во избежание потери массового рынка, начинает выпуск своих ныне широко известных серий ПК IBM PC/XT/AT и PS/2, открывших новую эпоху персональной ВТ. Выход на арену ПК-индустрии гиганта IBM ставит производство ПК на промышленную основу, что позволяет решить целый ряд важных для пользователя вопросов (стандартизация, унификация, развитое программное обеспечение и др.), которым фирма уделяла большое внимание уже в рамках производства серий IBM/360 и IBM/370. Можно с полным основанием полагать, что за короткий период времени, прошедший с дебюта Altair-8800 до IBM PC, к ВТ приобщилось больше людей, чем за весь долгий период — от аналитической машины Бэбиджа до изобретения первых ИС.

Первой ЭВМ, открывающей собственно класс супер-ЭВМ, можно считать модель Amdahl 470V16, созданную в 1975 г. и совместимую с IBM-серией. Машина использо-вала эффективный принцип распараллеливания на основе конвейерной обработки команд, а элементная база использовала БИС-технологию. В настоящее время к классу супер-ЭВМ относят модели, имеющие среднее быстродействие не менее 20 мегафлопсов (1 мегафлопс = 1 млн операций в с плавающей точкой в секунду). Первой моделью с такой производительностью явилась во многом уникальная ЭВМ ILLIAC-IV, созданная в 1975 г. в США и имеющая максимальное быстродействие порядка 50 мегафлопсов. Данная модель оказала огромное влияние на последующее развитие супер-ЭВМ с матричной архитектурой. Яркая страница в истории супер-ЭВМ связана с Cray-серией С. Крея, первая модель Cray-1 которой была создана в 1976 г. и имела пиковое быстродействие в 130 мегафлопсов. Архитектура модели базировалась на конвейерном принципе векторной и скалярной обработки данных с элементной базой на СБИС. Именно данная модель положила начало классу современных супер-ЭВМ. Следует отметить, что не смотря на ряд интересных архитектурных решений, успех модели был достигнут, в основном, за счет удачных технологических решений. Последующие модели Cray-2, Cray Х-МР, Cray-3, Cray-4 довели производительность серии до порядка 10 тыс. мегафлопсов, а модель Cray МР, использующая новую архитектуру на 64 процессорах и элементную базу на новых кремниевых микросхемах, обладала пиковой производительностью порядка 50 гигафлопсов.

Завершая экскурс в историю современной ВТ с той или иной детализацией отдельных ее этапов, следует сделать несколько существенных замечаний. Прежде всего, имеет место все более гладкий переход одного поколения ЭВМ к другому, когда идеи нового поколения в той или иной мере созревают и даже реализуются в предыдущем поколении. Особенно это заметно при переходе на ИС-технологию производства ВТ, когда определяющий акцент поколений все больше смещается с элементной базы на другие показатели: логическая архитектура, программное обеспечение, интерфейс с пользователем, сферы приложений и др. Появляется самая разнообразная ВТ, характеристики которой не укладываются в традиционные классификационные рамки; складывается впечатление, что мы находимся в начале своего рода универсализации ВТ, когда все ее классы стремятся к нивелированию своих вычислительных возможностей. Многие элементы пятого поколения в той или иной мере характерны и в наши дни.

|

Первая ЭВМ ENIAC была создана в конце 1945 г. в США.

Основные идеи, по которым долгие годы развивалась вычислительная техника, были сформулированы в 1946 г. американским математиком Джоном фон Нейманом. Они получили название архитектуры фон Неймана.

В 1949 году была построена первая ЭВМ с архитектурой фон Неймана – английская машина EDSAC. Годом позже появилась американская ЭВМ EDVAC.

В нашей стране первая ЭВМ была создана в 1951 году. Называлась она МЭСМ — малая электронная счетная машина. Конструктором МЭСМ был Сергей Алексеевич Лебедев.

Серийное производство ЭВМ началось в 50-х годах XX века.

Электронно-вычислительную технику принято делить на поколения, связанные со сменой элементной базы. Кроме того, машины разных поколений различаются логической архитектурой и программным обеспечением, быстродействием, оперативной памятью, способом ввода и вывода информации и т.д.

Первое поколение ЭВМ — ламповые машины 50-х годов. Скорость счета самых быстрых машин первого поколения доходила до 20 тысяч операций в секунду. Для ввода программ и данных использовались перфоленты и перфокарты. Поскольку внутренняя память этих машин была невелика (могла вместить в себя несколько тысяч чисел и команд программы), то они, главным образом, использовались для инженерных и научных расчетов, не связанных с переработкой больших объемов данных. Это были довольно громоздкие сооружения, содержавшие в себе тысячи ламп, занимавшие иногда сотни квадратных метров, потреблявшие электроэнергию в сотни киловатт. Программы для таких машин составлялись на языках машинных команд, поэтому программирование в те времена было доступно немногим.

В 1949 году в США был создан первый полупроводниковый прибор, заменяющий электронную лампу. Он получил название транзистор. В 60-х годах транзисторы стали элементной базой для ЭВМ второго поколения. Переход на полупроводниковые элементы улучшил качество ЭВМ по всем параметрам: они стали компактнее, надежнее, менее энергоемкими. Быстродействие большинства машин достигло десятков и сотен тысяч операций в секунду. Объем внутренней памяти возрос в сотни раз по сравнению с ЭВМ первого поколения. Большое развитие получили устройства внешней (магнитной) памяти: магнитные барабаны, накопители на магнитных лентах. Благодаря этому появилась возможность создавать на ЭВМ информационно-справочные, поисковые системы (это связано с необходимостью длительно хранить на магнитных носителях большие объемы информации). Во времена второго поколения активно стали развиваться языки программирования высокого уровня. Первыми из них были ФОРТРАН, АЛГОЛ, КОБОЛ. Программирование как элемент грамотности стало широко распространяться, главным образом среди людей с высшим образованием.

Третье поколение ЭВМ создавалось на новой элементной базе — интегральных схемах: на маленькой пластине из полупроводникового материала, площадью менее 1 см2 монтировались сложные электронные схемы. Их назвали интегральными схемами (ИС). Первые ИС содержали в себе десятки, затем — сотни элементов (транзисторов, сопротивлений и др.). Когда степень интеграции (количество элементов) приблизилась к тысяче, их стали называть большими интегральными схемами — БИС; затем появились сверхбольшие интегральные схемы — СБИС. ЭВМ третьего поколения начали производиться во второй половине 60-х годов, когда американская фирма IBM приступила к выпуску системы машин IBM-360. В Советском Союзе в 70-х годах начался выпуск машин серии ЕС ЭВМ (Единая Система ЭВМ). Переход к третьему поколению связан с существенными изменениями архитектуры ЭВМ. Появилась возможность выполнять одновременно несколько программ на одной машине. Такой режим работы называется мультипрограммным (многопрограммным) режимом. Скорость работы наиболее мощных моделей ЭВМ достигла нескольких миллионов операций в секунду. На машинах третьего поколения появился новый тип внешних запоминающих устройств — магнитные диски. Широко используются новые типы устройств ввода-вывода: дисплеи, графопостроители. В этот период существенно расширились области применения ЭВМ. Стали создаваться базы данных, первые системы искусственного интеллекта, системы автоматизированного проектирования (САПР) и управления (АСУ). В 70-е годы получила мощное развитие линия малых (мини) ЭВМ.

Очередное революционное событие в электронике произошло в 1971 году, когда американская фирма Intel объявила о создании микропроцессора. Микропроцессор — это сверхбольшая интегральная схема, способная выполнять функции основного блока компьютера — процессора. Первоначально микропроцессоры стали встраивать в различные технические устройства: станки, автомобили, самолеты. Соединив микропроцессор с устройствами ввода-вывода, внешней памяти, получили новый тип компьютера: микроЭВМ. МикроЭВМ относятся к машинам четвертого поколения. Существенным отличием микроЭВМ от своих предшественников являются их малые габариты (размеры бытового телевизора) и сравнительная дешевизна. Это первый тип компьютеров, который появился в розничной продаже.

Самой популярной разновидностью ЭВМ сегодня являются персональные компьютеры (ПК). Первый ПК появился на свет в 1976 году в США. С 1980 года «законодателем мод» на рынке ПК становится американская фирма IBM. Ее конструкторам удалось создать такую архитектуру, которая стала фактически международным стандартом на профессиональные ПК. Машины этой серии получили название IBM PC (Personal Computer). Появление и распространение ПК по своему значению для общественного развития сопоставимо с появлением книгопечатания. Именно ПК сделали компьютерную грамотность массовым явлением. С развитием этого типа машин появилось понятие «информационные технологии», без которых уже становится невозможным обойтись в большинстве областей человеческой деятельности.

Другая линия в развитии ЭВМ четвертого поколения, это — суперкомпьютер. Машины этого класса имеют быстродействие сотни миллионов и миллиарды операций в секунду. Суперкомпьютер – это многопроцессорный вычислительный комплекс.

Компьютеры будущего

Будущее может быть разным, и путей к нему тоже много, но ни то, ни другое предсказать невозможно. И все же кое-какие широкие штрихи набросать можно, причем в большинстве сценариев прогресс приводит к изменению способа нашего общения, объема информации, с которой нам придется иметь дело, и, возможно, даже наших природных способностей.

Технология микропроцессоров уже приближается к фундаментальным ограничениям. Следуя закону Мура, к 2010 - 2020 годам размеры транзистора должны уменьшиться до четырех-пяти атомов. Рассматриваются многие альтернативы, но, если они не будут реализованы в массовом производстве, закон Мура перестанет работать. Этот закон (вернее, прогноз соучредителя Intel Гордона Мура) гласит, что плотность транзисторов в микросхеме удваивается каждые полтора года, и все последние 20 лет он выполнялся. Если в начале нового столетия рост производительности микропроцессоров прекратится, в вычислительной технике наступит стагнация. Но возможно, что вместо этого произойдет технологический скачок с тысячекратным увеличением мощности компьютеров.

Последний сценарий очень привлекателен. Мало того, что целый ряд технологий получит необходимое развитие, разработки в одних областях помогут продвижению других. Инженер Рэй Курцвейл (Ray Kurzweil) называет это "законом взаимного усиления выгод". Когда в развитии какой-то области происходит скачок, время между открытиями сокращается и предыдущие достижения накладываются на следующие, что еще больше ускоряет прогресс.

К технологиям, способным экспоненциально увеличивать обрабатывающую мощность компьютеров, следует отнести молекулярные или атомные технологии; ДНК и другие биологические материалы; трехмерные технологии; технологии, основанные на фотонах вместо электронов; и наконец, квантовые технологии, в которых используются элементарные частицы. Если на каком-нибудь из этих направлений удастся добиться успеха, то компьютеры могут стать вездесущими. А если таких успешных направлений будет несколько, то они распределятся по разным нишам. Например, квантовые компьютеры будут специализироваться на шифровании и поиске в крупных массивах данных, молекулярные - на управлении производственными процессами и микромашинах, а оптические - на средствах связи.

Возможности современного производства пока не позволяют наладить недорогое массовое изготовление подобных устройств. Однако многие ученые уверены в том что решение будет найдено. Уже есть свидетельства определенного взаимного усиления выгод по Курцвейлу. Например, эффективность "генетических чипов" удалось повысить (а стоимость - понизить) благодаря использованию других чипов, содержащих полмиллиона маленьких зеркал, - первоначально они предназначались для оптических систем связи. Цифровая микрозеркальная система (Digital Micromirror Device, DMD) от Texas Instruments применялась даже для демонстрации последней серии фильма "Звездные войны". Точно так же микромашины (micro-electro-mechanical systems, MEMS) изготавливаются с применением технологии травления, разработанной для производства электронных микросхем. В этих устройствах датчики сочетаются с микроприводами, что позволяет им выполнять физические действия. Возможно даже, что MEMS помогут в создании компьютеров атомных размеров, необходимых для квантовых вычислений.

В наступающем веке вычислительная техника сольется не только со средствами связи и машиностроения, но и с биологическими процессами, что откроет такие возможности, как создание искусственных имплантантов, интеллектуальных тканей, разумных машин, "живых" компьютеров и человеко-машинных гибридов. Если закон Мура проработает еще 20 лет, уже в 2020 году компьютеры достигнут мощности человеческого мозга - 20000000 миллиардов операций в секунду (это 100 млрд. нейронов умножить на 1000 связей одного нейрона и на 200 возбуждений в секунду). А к 2060 году компьютер сравняется по силе разума со всем человечеством. Одной вероятности подобной перспективы достаточно, чтобы отбросить любые опасения по поводу применения био- и генной инженерии для расширения способностей человека.

"Я не верю в научную фантастику типа "Звездного пути", где через 400 лет люди остаются прежними, - сказал астрофизик Стивен Хокинг (Stephen Hawking), выступая в прошлом году в Белом доме. - По-моему, человеческая раса и сложность ее ДНК очень скоро начнут меняться".

Однако для этого вычислительная техника будущего столетия должна вобрать в себя некоторые новейшие технологии. Ниже приводится обзор нескольких новых технологий и процессов, способных не только обеспечить продолжение действия закона Мура, но и превратить его из линейного в прогрессирующий.

Молекулярные компьютеры

Недавно компания Hewlett-Packard объявила о первых успехах в изготовлении компонентов, из которых могут быть построены мощные молекулярные компьютеры. Ученые из HP и Калифорнийского университета в Лос-Анджелесе (UCLA) объявили о том, что им удалось заставить молекулы ротаксана переходить из одного состояния в другое - по существу, это означает создание молекулярного элемента памяти.

Следующим шагом должно стать изготовление логических ключей, способных выполнять функции И, ИЛИ и НЕ. Весь такой компьютер может состоять из слоя проводников, проложенных в одном направлении, слоя молекул ротаксана и слоя проводников, направленных в обратную сторону. Конфигурация компонентов, состоящих из необходимого числа ячеек памяти и логических ключей, создается электронным способом. По оценкам ученых HP, подобный компьютер будет в 100 млрд. раз экономичнее современных микропроцессоров, занимая во много раз меньше места.

Сама идея этих логических элементов не является революционной: кремниевые микросхемы содержат миллиарды таких же. Но преимущества в потребляемой энергии и размерах способны сделать компьютеры вездесущими. Молекулярный компьютер размером с песчинку может содержать миллиарды молекул. А если научиться делать компьютеры не трехслойными, а трехмерными, преодолев ограничения процесса плоской литографии, применяемого для изготовления микропроцессоров сегодня, преимущества станут еще больше.

Кроме того, молекулярные технологии сулят появление микромашин, способных перемещаться и прилагать усилие. Причем для создания таких устройств можно применять даже традиционные технологии травления. Когда-нибудь эти микромашины будут самостоятельно заниматься сборкой компонентов молекулярного или атомного размера.

Первые опыты с молекулярными устройствами еще не гарантируют появления таких компьютеров, однако это именно тот путь, который предначертан всей историей предыдущих достижений. Массовое производство действующего молекулярного компьютера вполне может начаться где-нибудь между 2005 и 2015 годами.

Биокомпьютеры

Применение в вычислительной технике биологических материалов позволит со временем уменьшить компьютеры до размеров живой клетки. Пока эта чашка Петри, наполненная спиралями ДНК, или нейроны, взятые у пиявки и подсоединенные к электрическим проводам. По существу, наши собственные клетки - это не что иное, как биомашины молекулярного размера, а примером биокомпьютера, конечно, служит наш мозг.

Ихуд Шапиро (Ehud Shapiro) из Вейцманоского института естественных наук соорудил пластмассовую модель биологического компьютера высотой 30 см. Если бы это устройство с

|

|

|