|

Глава 9. Квантовые компьютеры.

|

|

|

|

Для любого, кто не знаком с этим предметом, квантовое вычисление звучит как название новой технологии, возможно, самой последней в знаменитом ряду, включающем механическое вычисление, транзисторно-электронное вычисление, вычисление на кремниевых кристаллах и т. д. Но истина в том, что даже существующие компьютерные технологии зависят от микроскопических квантово-механических процессов. (Конечно, все физические процессы являются квантово-механическими, но здесь я имею в виду только те, для которых классическая — т. е. неквантовая — физика дает очень неточные предсказания). Если существует тенденция к получению даже более быстрых компьютеров с более компактным аппаратным обеспечением, технология должна стать в этом смысле даже более «квантовомеханической» просто потому, что квантово-механические эффекты доминируют во всех достаточно маленьких системах. Но если бы дело было только в этом, квантовое вычисление вряд ли смогло бы фигурировать в любом фундаментальном объяснении структуры реальности, Поскольку в нем не было бы ничего фундаментально нового. Все современные компьютеры, какие бы квантово-механические процессы они не использовали, - всего лишь различные технологические исполнения одной и той же классической идеи универсальной машины Тьюринга. Именно поэтому все существующие компьютеры имеют в сущности один и тот же репертуар вычислений: отличие состоит только в скорости, емкости памяти и устройствах ввода-вывода. Это все равно, что сказать, что даже самый непритязательный современный домашний компьютер можно запрограммировать для решения любой задачи или передачи любой среды, которую могут передать наши самые Мощные компьютеры, при условии установки на него дополнительной памяти, достаточно долгом времени обработки и наличии аппаратного Обеспечения, подходящего для демонстрации результатов работы.

|

|

|

Квантовое вычисление — это нечто большее, чем просто более быстрая и миниатюрная технология реализации машин Тьюринга. Квантовый компьютер — это машина, использующая уникальные квантово-механические эффекты, в особенности, интерференцию. для выполнения совершенно новых видов вычислений, которые, даже в принципе, невозможно выполнить ни на одной машине Тьюринга, а следовательно, ни на каком классическом компьютере. Таким образом, квантовое вычисление — это ни что иное, как принципиально новый способ использования природы.

Позвольте мне конкретизировать это заявление. Самыми первыми изобретениями для использования природы были инструменты, управляемые силой человеческих мускулов. Они вывели наших предков на новый этап развития, но страдали от ограничения, которое заключалось в том, что они требовали постоянного внимания и усилий человека во время их использования. Дальнейшее развитие технологии позволило преодолеть это ограничение: люди сумели приручить некоторых животных и растения, изменив биологическую адаптацию этих организмов, приблизив их к человеку. Таким образом, урожай рос, а сторожевые собаки охраняли дом, пока их владельцы спали. Еще один новый вид технологии появился, когда люди начали не просто использовать существующие адаптации (и существующие небиологические явления, например, огонь), а создали совершенно новые для мира адаптации в виде кирпичей, колес, гончарных и металлических изделий и машин. Чтобы сделать это, они должны были поразмыслить и понять законы природы, управляющие вселенной, включая, как я уже объяснил, не только ее поверхностные аспекты, но и лежащую в основе структуру реальности. Последовали тысячи лет развития этого вида техники — использование некоторых материалов, сил и энергий физики. В двадцатом веке, когда изобретение компьютеров позволило осуществить обработку сложной информации вне человеческого мозга, к этому списку добавилась информация. Квантовое вычисление, которое сейчас находится в зачаточном состоянии, — качественно новый этап этого движения. Это будет первая технология, которая позволит выполнять полезные задачи при участии параллельных вселенных. Квантовый компьютер сможет распределить составляющие сложной задачи между множеством параллельных вселенных, а затем поделиться результатами.

|

|

|

Я уже говорил о важности универсальности вычислений — о том, что один физически возможный компьютер может, при наличии достаточного времени и памяти, выполнить любое вычисление, которое может выполнить любой другой физически возможный компьютер. Законы физики, как мы понимаем их сейчас, допускают универсальность вычисления. Однако, настоящего определения универсальности недостаточно, чтобы считать ее полезной или важной в общей схеме всего. Она просто означает, что, в конечном итоге, универсальный компьютер сможет делать то, что может делать любой другой компьютер. Другими словами, он универсален при наличии достаточного времени. А что делать, если времени недостаточно? Представьте универсальный компьютер, который мог бы выполнить только одно вычислительное действие за всю жизнь вселенной. Его универсальность по-прежнему оставалась бы глубоким свойством реальности? Вероятно, нет. Говоря в общем, можно критиковать это узкое понятие универсальности, потому что оно относит любую задачу к разряду находящихся в репертуаре компьютера, не принимая во внимание физические ресурсы, которые придется израсходовать компьютеру на выполнение этой задачи. Так, например, мы рассмотрели пользователя виртуальной реальности, который готов отправиться в виртуальную реальность с остановкой мозга на миллиарды лет и повторным его запуском: в течение этого времени компьютер вычислит, что показывать дальше. Такое отношение вполне уместно при обсуждении верхних пределов виртуальной реальности. Но при рассмотрении ее полезности, или, что даже более важно, фундаментальной роли, которую она играет в структуре реальности, нам следует быть более разборчивыми. Эволюция никогда бы не произошла, если бы задача передачи определенных свойств самых первых, простейших сред обитания не была легко обрабатываемой (т. е. вычислимой в течение разумного периода времени) при использовании в качестве компьютеров легко доступных молекул. Точно так же никогда не началось бы развитие науки и техники, если бы для создания инструмента из камня понадобились тысячи лет размышлений. Более того, то, что было истиной в самом начале, осталось абсолютным условием прогресса на каждом этапе. Универсальность вычислений была бы бесполезна для генов, независимо от количества содержащегося в них знания, если бы передача их организма не была легко обрабатываемой задачей — скажем, если бы один репродуктивный цикл занимал миллиарды лет.

|

|

|

Таким образом, факт существования сложных организмов и непрерывного ряда постепенно совершенствующихся изобретений и научных теорий (таких, как механика Галилея, механика Ньютона, механика Эйнштейна, квантовая механика,...) говорит о том, универсальность вычислений какого рода существует в реальности. Он говорит нам, что действительные законы физики, по крайней мере, до сих пор, поддаются последовательной аппроксимации с помощью теорий, дающих лучшие объяснения и предсказания, и что задача открытия каждой теории при наличии предыдущей легко решалась с помощью вычислений при наличии уже известных законов и уже имеющейся технологии. Структура реальности должна быть многоуровневой (какой она и была) для более легкого доступа к самой себе. Подобным образом, если рассматривать саму эволюцию как вычисление, она говорит нам, что существовало достаточно много жизнеспособных организмов, закодированных ДНК, что позволило вычислить (т.е. эволюционировать) организмы с более высокой степенью адаптации, используя ресурсы, предоставленные их предками с низкой степенью адаптации. Таким образом, мы можем сделать вывод, что законы физики, кроме того, что удостоверяют свою собственную постижимость через принцип Тьюринга, гарантируют, что соответствующие эволюционные процессы, такие, как жизнь и мышление, не являются трудоемкими и требуют не слишком много дополнительных ресурсов, чтобы произойти в реальности.

|

|

|

Итак, законы физики не только позволяют (или, как я доказал, требуют) существование жизни и мышления, но требуют от них эффективности, в некотором уместном смысле. Для выражения этого важного свойства реальности современные анализы универсальности обычно постулируют компьютеры, универсальные даже в более строгом смысле, чем того потребовал бы в данной ситуации принцип Тьюринга: универсальные генераторы виртуальной реальности не только возможны, их можно построить так, что они не потребуют нереально больших ресурсов для передачи простых аспектов реальности. С настоящего момента, говоря об универсальности, я буду иметь в виду именно такую универсальность, пока не приведу другого определения.

Насколько эффективно можно передать данные аспекты реальности? Другими словами, какие вычисления можно практически выполнить за данное время и при данных финансовых возможностях? Это основной вопрос теории вычислительной сложности, которая, как я уже сказал, занимается изучением ресурсов, необходимых для выполнения данных вычислительных задач. Теория сложности все еще в достаточной степени не объединена с физикой и потому не дает много количественных ответов. Однако она достигла успеха в определении полезного приближенного различия между легко- и труднообрабатываемыми вычислительными задачами. Общий подход лучше всего проиллюстрировать на примере. Рассмотрим задачу умножения двух достаточно больших чисел, скажем. 4 220 851 и 2594209. Многие из нас помнят тот метод умножения, которому мы научились в детстве. Нужно по очереди перемножить каждую цифру одного числа на каждую цифру другого и, сложив результаты, дать окончательный ответ, в данном случае 10949769651859. Вероятно, многие не захотят признать, что эта утомительная процедура делает умножение «легко обрабатываемым» хоть в каком-то обыденном смысле этого слова. (В действительности, существуют более эффективные методы умножения больших чисел, но этот весьма нагляден). Однако с точки зрения теории сложности, которая имеет дело с массивными задачами, решаемыми компьютерами которые не подвержены скуке и почти никогда не ошибаются, этот метод определенно попадает в категорию «легко обрабатываемых».

|

|

|

В соответствии со стандартным определением для «легкости обработки» важно не действительное время, затрачиваемое на умножение конкретной пары чисел, а важен факт, что при применении того же самого метода даже к большим числам, время увеличивается не слишком резко. Возможно это удивит вас, но этот весьма косвенный метод определения легкости обработки очень хорошо работает на практике для многих (хотя и не всех) важных классов вычислительных задач. Например, при умножении нетрудно увидеть, что стандартный метод можно использовать для умножения чисел, скажем, в десять раз больших, Приложив совсем незначительные дополнительные усилия. Ради доказательства предположим, что каждое элементарное умножение одной цифры на другую занимает у определенного компьютера одну микросекунду (включая время, необходимое для сложения, переходов и других операций, сопровождающих каждое элементарное умножение). При умножении семизначных чисел 4220851 и 2594209 каждую из семи цифр первого числа нужно умножить на каждую из семи цифр второго числа. Таким образом, общее время, необходимое для умножения (если операции выполняются последовательно), будет равно семи, умноженному на семь, или 49 микросекундам. При введении чисел, примерно в десять раз больших, содержащих по восемь цифр, время, необходимое для их умножения, будет равно 64 микросекундам: увеличение составляет всего 31%.

Ясно, что числа из огромного диапазона — безусловно содержащего любые числа, которые когда-либо были измерены как численные значения физических переменных — можно перемножить за крошечную долю секунды. Таким образом, умножение действительно легко поддается обработке для любых целей в пределах физики (или, по крайней мере, в пределах существующей физики). Вероятно, за пределами физики могут появиться практические причины умножения гораздо больших чисел. Например, для шифровальщиков огромный интерес представляют произведения простых чисел, состоящих примерно из 125 цифр. Наша гипотетическая машина могла бы умножить два таких простых числа, получив произведение, состоящее из 250 цифр, примерно за одну сотую секунды. За одну секунду она могла бы перемножить два тысячезначных числа, а современные компьютеры легко могут осуществить более точный расчет этого времени. Только некоторые исследователи эзотерических областей чистой математики заинтересованы в выполнении таких непостижимо огромных умножений, однако, мы видим, что даже у них нет причины считать умножение трудно обрабатываемым.

Напротив, разложение на множители, по сути процесс, обратный умножению, кажется гораздо сложнее. В начале вводится одно число, скажем, 10949769651859, задача заключается в том, чтобы найти два множителя, меньших числа, произведение которых равно 10949769651859. Поскольку мы только что умножили эти числа, мы знаем, что в этом случае ответ будет 4220851 и 2594209 (и поскольку оба эти числа простые, это единственно правильный ответ). Но не обладая таким внутренним знанием, как мы нашли бы эти множители? В поисках простого метода вы обратитесь к детским воспоминаниям, но впустую, поскольку такого метода не существует.

Самый очевидный метод разложения на множители — делить вводимое число на все возможные множители, начиная с 2 и продолжая каждым нечетным числом, до тех пор, пока введенное число не разделится без остатка. По крайней мере, один из множителей (принимая, что введенное число не является простым) не может быть больше квадратного корня введенного числа, что позволяет оценить, сколько времени может занять этот метод. В рассматриваемом нами случае наш компьютер найдет меньший из двух множителей, 2 594 209, примерно за одну секунду. Однако, если вводимое число будет в десять раз больше, а его квадратный корень примерно в три раза больше, то разложение его на множители по этому методу займет в три раза больше времени. Другими словами, увеличение вводимого числа на один разряд уже утроит время обработки. Увеличение его еще на один разряд снова утроит это время и т. д. Таким образом, время обработки будет увеличиваться в геометрической прогрессии, т.е. экспоненциально, с увеличением количества разрядов в раскладываемом на множители числе. Разложение на множители числа с 25-значными множителями по этому методу заняло бы все компьютеры на Земле на несколько веков.

Этот метод можно усовершенствовать, однако всем современным методам разложения числа на множители присуще это свойство экспоненциального увеличения. Самое большое число, которое было «в гневе» (а это было действительно так) разложено на множители, — число, множители которого тайно выбрали одни математики, чтобы бросить вызов другим математикам, — имело 129 разрядов. Разложение на множители выполнили с помощью сети Интернет глобальными совместными усилиями, задействовав тысячи компьютеров. Дональд Кнут, специалист по вычислительной технике, подсчитал, что разложение на множители 250-значного числа при использовании самых эффективных из известных методов, с помощью сети, состоящей из миллиона компьютеров, заняло бы более миллиона лет. Такие вещи трудно оценить, но даже если Кнут чрезмерно пессимистичен, то попробуйте хотя бы взять числа на несколько разрядов большие, и задача во много раз усложнится. Именно это мы имеем в виду, когда говорим, что разложение на множители больших чисел с трудом поддается обработке. Все это весьма отличается от умножения, где как мы видели, задачу умножения пары 250-значных чисел можно элементарно решить с помощью домашнего компьютера. Никто не может даже представить себе, как можно разложить на множители числа, состоящие из тысячи или миллиона разрядов.

По крайней мере, этого никто не мог представить до недавнего Времени.

В 1982 году физик Ричард Фейнман занимался компьютерным моделированием квантово-механических объектов. Его отправной точкой было нечто, что уже было известно в течение некоторого времени, однако важность чего не оценили, а именно, что задача предсказания поведения квантово-механических систем (или, как мы можем это описать, Передача квантово-механических сред в виртуальной реальности), в общем случае, с трудом поддается обработке. Одна из причин того, что важность этого не оценили, в том, что никто и не ожидал, что предсказание интересных физических явлений с помощью компьютера будет особо легким. Возьмите, например, прогноз погоды или землетрясения. Несмотря на то, что известны нужные уравнения, сложность их применения для реальных ситуаций общеизвестна. Все это недавно вынесли на всеобщее обозрение в популярных книгах и статьях по хаосу и «эффекту бабочки». Эти эффекты не ответственны за трудность обработки о которой говорил Фейнман, по простой причине, что они имеют место только в классической физике — т. е. не в реальности, поскольку реальность квантово-механическая. Тем не менее, я хочу сделать несколько замечаний относительно классических «хаотических» движений, только чтобы подчеркнуть достаточно различный характер невозможности получения классических и квантовых предсказаний.

Теория хаоса касается ограничений получения предсказаний в классической физике, проистекающих из факта внутренней неустойчивости всех классических систем. «Неустойчивость», о которой идет речь, не имеет ничего общего с какой-либо тенденцией буйного поведения или распада. Она связана с чрезмерной чувствительностью к начальным условиям. Допустим, что нам известно настоящее состояние какой-то физической системы, например, комплекта бильярдных шаров, катающихся по столу. Если бы система подчинялась законам классической физики, что она и делает в хорошем приближении, то мы смогли бы определить ее будущее поведение (скажем, попадет ли определенный шар в лузу) из соответствующих законов движения точно так же, как мы можем предсказать солнечное затмение или парад планет, исходя из этих же законов. Но на практике мы никогда не можем абсолютно точно определить начальные положения и скорости. Таким образом, возникает вопрос: если мы знаем их с некоторой разумной степенью точности, можем ли мы предсказать их будущее поведение с разумной степенью точности? Обычный ответ: не можем. Разница между реальной траекторией и предсказанной траекторией, вычисленной из слегка неточных данных, стремится расти экспоненциально и нерегулярно («хаотически») во времени, так что через некоторое время первоначальное состояние, содержащее небольшую погрешность, уже не сможет быть ключом к поведению системы. Компьютерное предсказание говорит о том, что движение планет, классическая предсказуемость в миниатюре, — нетипичная классическая система. Чтобы предсказать поведение типичной классической системы всего лишь через небольшой промежуток времени, необходимо определить начальное состояние этой системы с невозможно высокой точностью. Поэтому говорят, что, в принципе, бабочка, находящаяся в одном полушарии, взмахом своих крылышек может вызвать ураган в другом полушарии. Неспособность дать прогноз погоды и тому подобное приписывают невозможности учесть каждую бабочку на планете.

Однако реальные ураганы и реальные бабочки подчиняются не классической механике, а квантовой теории. Неустойчивость, быстро увеличивающая небольшие неточности определения классического начального состояния, просто не является признаком квантово-механических систем. В квантовой механике небольшие отклонения от точно определенного начального состояния стремятся вызвать всего лишь небольшие отклонения от предсказанного конечного состояния. А точное предсказание сделать сложно из-за совсем другого эффекта.

Законы квантовой механики требуют, чтобы объект, который первоначально находится в данном положении (во всех вселенных), «распространялся» в смысле мультиверса. Например, фотон и его двойники из других вселенных отправляются из одной и той же точки светящейся нити накала, но затем движутся в миллиардах различных направлений. Когда мы позднее проводим измерение того, что произошло, мы тоже становимся отличными друг от друга, так как каждая наша копия видит то, что произошло в ее конкретной вселенной. Если рассматриваемым объектом является атмосфера Земли, то ураган мог произойти, Скажем, в 30% вселенных и не произойти в остальных 70%. Субъективно мы воспринимаем это как единственный непредсказуемый или «случайный» результат, хотя если принять во внимание существование мультиверса, все результаты действительно имели место. Это многообразие параллельных вселенных — настоящая причина непредсказуемости погоды. Наша неспособность точно измерить начальные состояния тут абсолютно ни при чем. Даже знай мы начальные состояния точно, многообразие, а следовательно, и непредсказуемость движения, все равно имели бы место. С другой стороны, в отличие от классического случая, поведение воображаемого мультиверса с немного отличными начальными состояниями не слишком отличалось бы от поведения реального мультиверса: он мог пострадать от урагана в 30,000001% своих вселенных и не пострадать в оставшихся 69,999999%.

В действительности взмах крылышек бабочки не вызывает ураганы, потому что классическое явление хаоса зависит от совершенного Детерминизма, который не присутствует ни в одной вселенной. Рассмотрим группу идентичных вселенных в тот момент, когда в каждой из них конкретная бабочка взмахнула крылышками вверх. Рассмотрим вторую группу вселенных, которая в этот же самый момент идентична первой за исключением того, что в ней крылышки бабочки опущены вниз. Подождем несколько часов. Квантовая механика предсказывает, что если не возникнут исключительные обстоятельства (например, кто-нибудь, наблюдающий за бабочкой, нажмет кнопку, чтобы взорвать ядерную бомбу при взмахе ее крылышек), две группы вселенных, практически идентичные друг Другу в начале, останутся практически идентичными. Но каждая группа внутри самой себя значительно видоизменилась. Каждая группа включает вселенные с ураганами, вселенные без ураганов и даже очень маленькое количество вселенных, в которых вид бабочки спонтанно изменился из-за случайной перестановки всех ее атомов, или Солнце взорвалось из-за того, что все его атомы случайно вступили в ядерную реакцию в самом его центре. Даже в этом случае эти группы все еще очень похожи друг на друга. Во вселенных, где бабочка взмахнула крылышками вверх и произошли ураганы, эти ураганы действительно были непредсказуемы; но они произошли не из-за бабочки, поскольку почти идентичные ураганы произошли в других вселенных, где все было тем же самым, кроме того, что крылышки бабочки были опущены вниз.

Возможно, стоит подчеркнуть различие между непредсказуемостью и трудностью обработки. Непредсказуемость не имеет ничего общего с имеющимися вычислительными ресурсами. Классические системы непредсказуемы (или были бы таковыми, если бы существовали) из-за их чувствительности к начальным условиям. Квантовые системы не обладают такой чувствительностью, но они непредсказуемы, потому что в различных вселенных ведут себя по-разному, и поэтому в большинстве вселенных кажутся случайными. Ни в первом, ни во втором случае никакой объем вычислений не уменьшит непредсказуемость. Трудность обработки, напротив, — проблема вычислительных ресурсов. Она относится к ситуации, когда мы с легкостью могли бы сделать предсказание, если бы только могли выполнить необходимые вычисления, но мы не можем их выполнить, потому что требуются нереально большие ресурсы. Чтобы отделить проблемы непредсказуемости от проблем трудности обработки в квантовой механике, мы должны принять, что квантовые системы, в принципе, предсказуемы.

|

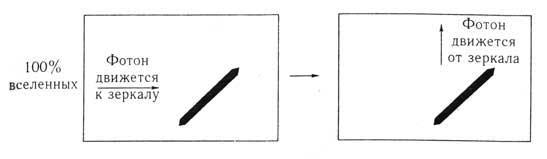

| Рис. 9.1. Действие обычного зеркала одинаково во всех вселенных |

|

| Рис. 9.2. Полупрозрачное зеркало разделяет первоначально идентичные вселенные на две равные группы, которые отличаются только траекторией движения одного фотона |

Квантовую теорию часто представляют как теорию, которая делает только вероятностные предсказания. Например, в эксперименте по интерференции со светонепроницаемой перегородкой со щелями, описанном в главе 2, можно видеть, что фотон попадает в любое место на «светлом» участке картины теней. Однако важно понимать, что для множества других экспериментов квантовая теория предсказывает единственный определенный результат. Другими словами, она предсказывает, что все вселенные окончатся с одним и тем же результатом, даже если на промежуточных стадиях эксперимента эти вселенные отличались друг от друга, и она предсказывает, каким будет этот результат. В таких случаях мы наблюдаем неслучайное явление интерференции. Такие явления может продемонстрировать интерферометр. Это оптический инструмент, состоящий главным образом из зеркал, как обычных (рисунок 9.1), так и полупрозрачных (какими пользуются фокусники и полицейские) (рисунок 9.2). Если фотон ударяется о полупрозрачное зеркало, то в половине вселенных он отскакивает от него точно так же, как отскочил бы от обычного зеркала. Однако в другой половине вселенных он проходит сквозь это зеркало, словно его нет.

|

| Рис. 9.3. Один фотон, проходящий через интерферометр. Положение зеркал (обычные зеркала показаны черным цветом, полусеребряные – серым) можно отрегулировать так, что интерференция между двумя разновидностями фотона (из разных вселенных) заставляет обе разновидности двигаться к выходу по одной и той же траектории от нижнего полупрозрачного зеркала |

Один фотон входит в интерферометр сверху слева, как показано на рисунке 9.3. Во всех вселенных, где проводят эксперимент, фотон и его двойники движутся к интерферометру по одной и той же траектории. Следовательно, эти вселенные идентичны. Но как только фотон ударяется о полупрозрачное зеркало, первоначально идентичные вселенные становятся различными. В половине из них фотон проходит через это зеркало и перемещается вдоль верхней стороны интерферометра. В остальных вселенных фотон отскакивает от зеркала и перемещается вдоль левой стороны интерферометра. Затем разновидности фотона в этих группах вселенных ударяются об обычные зеркала справа сверху и слева снизу соответственно и отскакивают от них. Таким образом, в конце они одновременно попадают на полупрозрачное зеркало справа снизу и интерферируют друг с другом. Не забывайте, что мы пускали в аппарат только один фотон, и в каждой вселенной по-прежнему находится только один фотон. Во всех вселенных этот фотон теперь ударился о правое нижнее зеркало. В половине вселенных он ударился об это зеркало слева, в другой половине — сверху. Между разновидностями фотона из этих двух групп вселенных произошла сильная интерференция. Суммарный эффект зависит от точной геометрии ситуации, но на рисунке 9.3 изображен тот случай, когда во всех вселенных фотон в конце движется вправо сквозь зеркало, и ни в одной вселенной он не передается или не отражается вниз. Таким образом, в конце эксперимента все вселенные так же идентичны, как и в начале. Они отличались и взаимодействовали друг с другом всего лишь долю минуты в промежуточном состоянии.

Это замечательное явление неслучайной интерференции — почти такое же неизбежное свидетельство существования мультиверса, как Я явление теней. Поскольку результат, описанный мной, несовместим ни с одной из двух возможных траекторий движения частицы в одной вселенной. Если мы, например, направим фотон вправо вдоль нижней стороны интерферометра, он, как и фотон из эксперимента, может пройти сквозь полупрозрачное зеркало. Но может и не пройти — иногда он отклоняется вниз. Точно так же фотон, направленный вниз, вдоль правой стороны интерферометра, может отклониться вправо, как в эксперименте с интерференцией, или просто двигаться прямо вниз. Таким образом, на какую бы траекторию вы не направили один фотон внутри аппарата, он будет появляться случайно. Результат можно предсказать только в том случае, когда между двумя траекториями произойдет интерференция. Следовательно, непосредственно перед окончанием эксперимента с интерференцией в аппарате присутствует нечто, что не может быть одним фотоном с одной траекторией: например, это не может выть просто фотон, который перемещается вдоль нижней стороны интерферометра. Там должно быть что-то еще, что мешает ему отскочить вниз. Там не может быть и просто фотон, который перемещается вдоль правой стороны интерферометра; там, опять, должно быть что-то еще, что мешает ему переместиться прямо вниз, как это могло бы произойти в некоторых случаях, если бы он был там один. Как и в случае с тенями, мы можем придумать дальнейшие эксперименты, чтобы показать, что это «что-то еще» обладает всеми свойствами фотона, который перемещается вдоль. Другой траектории и интерферирует с видимым нами фотоном, но ни с чем другим в нашей вселенной.

Поскольку в этом опыте присутствуют только два различных вида вселенных, вычисление того, что произойдет, займет только всего в два раза больше времени, чем заняло бы, если бы частица подчинялась классическим законам — скажем, если бы мы вычисляли траекторию движения бильярдного шара. Вряд ли коэффициент два сделает такие вычисления трудно обрабатываемыми. Однако, мы уже видели, что довольно легко достичь и гораздо более высокой степени многообразия. В экспериментах с тенями один фотон проходит через перегородку с несколькими маленькими отверстиями и попадает на экран. Предположим, что в перегородке тысяча отверстий. На экране есть места, куда может попасть фотон (и попадает в некоторых вселенных), и места, куда он попасть не может. Чтобы вычислить, может ли конкретная точка экрана принять фотон, мы должны вычислить эффекты взаимной интерференции разновидностей фотона из тысячи параллельных вселенных. В частности, мы должны вычислить тысячу траекторий движения фотона от перегородки до данной точки экрана, затем вычислить влияния этих фотонов друг на друга так, чтобы определить, всем ли им мешают достигнуть этой точки. Таким образом, мы должны выполнить примерно в тысячу раз больше вычислений, чем нам пришлось бы, если бы мы определяли, попадет ли в конкретную точку классическая частица.

Сложность такого рода вычислений показывает нам, что в квантово-механической среде происходит гораздо больше, чем (буквально) видит глаз. Я доказал, выражая критерий реальности доктора Джонсона на языке вычислительной сложности, что эта сложность — основная причина того, почему бессмысленно отрицать существование оставшейся части мультиверса. Но возможны гораздо более высокие степени многообразия, когда в интерференцию вовлекаются две или более взаимодействующих частицы. Допустим, что для каждой из двух взаимодействующих частиц открыта (скажем) тысяча траекторий. Тогда эта пара на промежуточном этапе эксперимента может оказаться в миллионе различных состояний, так что может быть до миллиона вселенных, которые будут отличаться тем, что делает эта пара частиц. Если бы взаимодействовали три частицы, то количество различных вселенных могло бы увеличиться до миллиарда; для четырех частиц — до триллиона и т.д. Таким образом, количество различных историй, которые нам пришлось бы вычислить, если бы мы захотели предсказать то, что произойдет в таких случаях, увеличивается экспоненциально с ростом числа взаимодействующих частиц. Именно поэтому задача вычисления поведения типичной квантовой системы труднообрабатываема в полном смысле этого слова.

Это именно та трудность обработки, которая волновала Фейнмана. Мы видим, что она не имеет ничего общего с непредсказуемостью: напротив, наиболее ясно она проявляется в квантовых явлениях с высокой степенью предсказуемости. Так происходит потому, что в таких явлениях один и тот же определенный результат имеет место во всех вселенных, однако этот результат — итог интерференции между огромным количеством вселенных, которые отличались друг от друга во время эксперимента. Все это в принципе можно предсказать из квантовой теории, да оно и не страдает излишней чувствительностью к начальным условиям. Но предсказать, что в таких экспериментах результат всегда будет одним и тем же, трудно потому, что для этого необходимо выполнить чрезмерно большой объем вычислений.

Трудность обработки, в принципе, является гораздо большим препятствием для универсальности, чем им когда-либо могла стать непредсказуемость. Я уже сказал, что абсолютно точная передача рулетки не нуждается (а на самом деле, и не должна нуждаться) в последовательности чисел, совпадающей с реальной. Подобным образом, мы не можем заранее подготовить передачу завтрашней погоды в виртуальной реальности. Но мы можем (или однажды сможем) осуществить передачу погоды, которая хотя и не будет такой же, как реальная погода, имевшая место в какой-то исторический день, но тем не менее, будет вести себя столь реалистично, что ни один пользователь, каким бы экспертом он ни был, не сможет отличить ее от настоящей погоды. То же самое касается и любой среды, которая не показывает эффекты квантовой интерференции (что означает большинство сред). Передача такой среды в виртуальной реальности — легкообрабатываемая вычислительная задача. Однако оказалось, что невозможно практически передать те среды, которые показывают эффекты квантовой интерференции. Не выполняя экспоненциально большие объемы вычислений, как мы можем быть уверены, что в этих случаях переданная нами среда никогда не сделает того, что из-за некоторого явления интерференции никогда не делает реальная среда?

Может показаться естественным вывод, что реальность все-таки не показывает настоящей универсальности вычислений, поскольку невозможно полезно передать явления интерференции. Однако, Фейнман сделал противоположный вывод и был совершенно прав! Вместо того, чтобы считать трудность обработки задачи передачи квантовых явлений препятствием, Фейнман счел ее благоприятной возможностью. Если, чтобы узнать исход эксперимента с интерференцией, необходимо выполнить так много вычислений, то сам факт проведения такого эксперимента и измерения его результатов равносилен выполнению сложного вычисления. Таким образом, рассуждал Фейнман, наверное все-таки можно было бы эффективно передать квантовые среды при условии, что компьютеру позволят проводить эксперименты над реальным квантово-механичееким объектом. Компьютер выбрал бы, какие измерения сделать на вспомогательной составляющей квантового аппаратного обеспечения во время проведения эксперимента, и включил бы результаты измерений в свои вычисления.

В действительности вспомогательное квантовое аппаратное обеспечение тоже было бы компьютером. Например, интерферометр мог бы действовать, как подобный прибор, и. как любой другой физический объект, его можно было бы считать компьютером. Сегодня мы назвали бы его специализированным квантовым компьютером. Мы «программируем» его, устанавливая зеркала так, чтобы создать определенную геометрию, и затем направляем один фотон на первое зеркало. В эксперименте с неслучайной интерференцией фотон всегда будет появляться в одном конкретном направлении, определяемом установкой зеркал, и мы можем интерпретировать это направление как указывающее результат вычисления. В более сложном эксперименте с несколькими взаимодействующими частицами такое вычисление запросто могло бы, как я уже объяснил, стать «труднообрабатываемым». Но

|

|

|