|

Метод наименьших квадратов и его предпосылки

|

|

|

|

Рассмотрим уравнение линейной множественной регрессии. Уравнение генеральной совокупности или модель регрессии запишем в виде

, (t =

, (t =  ), (2.1)

), (2.1)

где

– значения зависимой переменной с номером t;

– значения зависимой переменной с номером t;

– значения независимых переменных с номером t;

– значения независимых переменных с номером t;

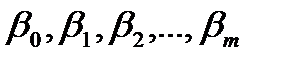

– параметры уравнения регрессии,

– параметры уравнения регрессии,  – константа или свободный член уравнения регрессии,

– константа или свободный член уравнения регрессии,  – коэффициенты уравнения регрессии;

– коэффициенты уравнения регрессии;

– значения случайного члена уравнения регрессии.

– значения случайного члена уравнения регрессии.

Предполагается, что εt независимы и нормально распределены с нулевым математическим ожиданием и постоянной дисперсией  , т. е.

, т. е.

N(0,

N(0,  ).

).

Термины «зависимая» и «независимые» для переменных не совсем удачны и означают лишь, что в этом случае значения зависимой переменной оцениваются на основе известных значений независимых переменных.

Приведём предпосылки спецификации классической регрессионной модели:

эндогенная, зависимая переменная объясняется m экзогенными, независимыми переменными;

эндогенная, зависимая переменная объясняется m экзогенными, независимыми переменными;

в общем случае уравнение регрессии включает константу;

в общем случае уравнение регрессии включает константу;

объём выборки n должен быть значительно больше числа объясняющих переменных m (считается, что каждый регрессор должен быть обеспечен не менее 6–7 наблюдениями);

объём выборки n должен быть значительно больше числа объясняющих переменных m (считается, что каждый регрессор должен быть обеспечен не менее 6–7 наблюдениями);

разность n–m–1 называется числом степеней свободы модели; чем она больше, тем надёжнее результаты оценивания;

разность n–m–1 называется числом степеней свободы модели; чем она больше, тем надёжнее результаты оценивания;

параметры уравнения регрессии

параметры уравнения регрессии  должны быть постоянными для всей выборки; это положение зачастую определяет выборку.

должны быть постоянными для всей выборки; это положение зачастую определяет выборку.

Кроме предпосылок спецификации модели необходимо выполнение ещё и предпосылок метода наименьших квадратов (МНК). Как известно, оценки параметров модели линейной регрессии обычно рассчитываются на основе МНК. Доказано, что эти оценки будут «хорошими», т.е. несмещёнными, эффективными и состоятельными, если будут выполняться следующие предпосылки относительно поведения остаточного члена  :

:

|

|

|

математическое ожидание

математическое ожидание  равно нулю для всех t, т.е. M(

равно нулю для всех t, т.е. M( ) = 0;

) = 0;  t;

t;

дисперсия

дисперсия  постоянна, т.е. D(

постоянна, т.е. D( ) = 0

) = 0  t, в этом случае говорят, что в остатках наблюдается гомоскедастичность; в противном случае – гетероскедастичность;

t, в этом случае говорят, что в остатках наблюдается гомоскедастичность; в противном случае – гетероскедастичность;

случайные отклонения

случайные отклонения  и

и  независимы друг от друга для t

независимы друг от друга для t  s, в этом случае говорят, что в остатках отсутствует какая-либо автокорреляция;

s, в этом случае говорят, что в остатках отсутствует какая-либо автокорреляция;

регрессоры и остатки должны быть независимыми.

регрессоры и остатки должны быть независимыми.

Кроме основных предпосылок, рассматриваются ещё две дополнительные – отсутствие между регрессорами сильной линейной зависимости (совершенной мультиколлинеарности) и что

N (0,

N (0,  En). Последняя предпосылка не влияет на качество оценок и необходима для проверки статистических гипотез и построения интервальных оценок.

En). Последняя предпосылка не влияет на качество оценок и необходима для проверки статистических гипотез и построения интервальных оценок.

Одна из задач эконометрики – тестирование выполнимости предпосылок и выработка методов оценивания при их нарушениях.

Оцененное уравнение регрессии будем записывать так:

, (t =

, (t =  ). (2.2)

). (2.2)

Здесь  – оценки параметров уравнения регрессии, а

– оценки параметров уравнения регрессии, а  – выборочная реализация случайного процесса

– выборочная реализация случайного процесса  .

.

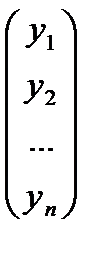

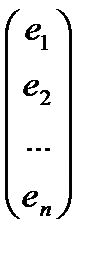

Представим уравнение генеральной совокупности и оценённое уравнение регрессии в матричной форме. Введём следующие обозначения:

Y =  , X =

, X =  , b =

, b =  , e =

, e =  , и т. д.

, и т. д.

Тогда уравнения регрессии (2.1) и (2.2) в матричной форме примут вид

Y = X  +

+  и Y = Xb + e. (2.3)

и Y = Xb + e. (2.3)

МНК-оценки параметров уравнения (2.1) рассчитываются из условия минимизации по b квадратичной формы:

Q(b) =  e = (Y – Xb)T(Y – Xb) = YTY – 2YTXb – bTXTXb.

e = (Y – Xb)T(Y – Xb) = YTY – 2YTXb – bTXTXb.

Продифференцируем Q(b) по b и приравняем результат к нулю:

= –2XTY – 2XTXb = 0.

= –2XTY – 2XTXb = 0.

Откуда имеем

b =  . (2.4)

. (2.4)

Это и есть МНК-оценка параметров уравнения (2.1).

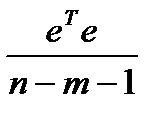

Кроме того, известно, что несмещённая оценка дисперсии случайного члена  равна

равна

=

=  =

=  =

=  ,

,

где  – оценённые по уравнению (2.2) значения зависимой переменной.

– оценённые по уравнению (2.2) значения зависимой переменной.

Свойства МНК-оценок

Остановимся более подробно на свойствах полученных оценок. Относительно уравнения множественной регрессии можно высказать те же предположения 1 – 4, что и для простой регрессии (заменив независимую переменную векторов независимых переменных), в том числе и предположения, лежащие в основе теоремы Гаусса-Маркова.

|

|

|

Рассмотрим математическое ожидание полученных оценок.

M(b) = M( ) = M(

) = M( ) =

) =  + M(

+ M( T

T  ) =

) =

=  + (XTX)M(XT

+ (XTX)M(XT  ) =

) =  , т. к. M(XT

, т. к. M(XT  ) = XTM(

) = XTM( ) =0, если X и

) =0, если X и  независимы.

независимы.

Здесь предполагается, что матрица Х детерминирована, а М( ) = 0. Таким образом, если регрессоры и остатки некоррелированны и математическое ожидание остатков равно нулю, то МНК-оценки являются несмещёнными. При доказательстве этого положения не использовались предположения 3 и 4 пункта 1.1, откуда следует, что МНК-оценки являются несмещённой до тех пор, пока регрессионные остатки имеют нулевое среднее и независимы от всех объясняющих переменных, даже если в них наблюдается гетероскедастичность и автокорреляция.

) = 0. Таким образом, если регрессоры и остатки некоррелированны и математическое ожидание остатков равно нулю, то МНК-оценки являются несмещёнными. При доказательстве этого положения не использовались предположения 3 и 4 пункта 1.1, откуда следует, что МНК-оценки являются несмещённой до тех пор, пока регрессионные остатки имеют нулевое среднее и независимы от всех объясняющих переменных, даже если в них наблюдается гетероскедастичность и автокорреляция.

Подсчитаем ковариационную матрицу полученных оценок. При этом будем иметь в виду, что ковариационная матрица остатков регрессии имеет вид  , т. к. регрессионные остатки взаимно независимы и гомоскедастичны (

, т. к. регрессионные остатки взаимно независимы и гомоскедастичны ( матрица размерности n

матрица размерности n  n):

n):

Cov(b) = М{(b-  )(b-

)(b-  )T} = M{(XTX)-1XT

)T} = M{(XTX)-1XT  TX(XTX)-1} = (XTX)-1XT

TX(XTX)-1} = (XTX)-1XT  X(XTX)-1 =

X(XTX)-1 =  (XTX)-1, т. к. M(

(XTX)-1, т. к. M( T) =

T) =  .

.

Итак, Cov(b) =  (XTX)-1. На главной диагонали этой матрицы находятся дисперсии соответствующих оценок, т. е. D (

(XTX)-1. На главной диагонали этой матрицы находятся дисперсии соответствующих оценок, т. е. D ( ) =

) =  .

.

|

|

|